電腦運算科學課程:

交織性研究方法

議題

電腦運算科學(computer science,CS)教育通常會磨練數學和工程技能,而忽略了道德、社會和政治的思辨。正如我們近年來所見,這樣的課程可能會致使社會不平等的擴張。例如,谷歌翻譯,將新聞從西班牙文譯成英文時,經常預設使用陽性代詞,從而强化「活躍的知識分子大都是男人」這樣的概念。同樣的,因詞向量(word embedding)的關係,典型歐裔美國人會與令人愉快的名稱連結起來,非裔美國人會與令人不愉快的連結起來,這再度加劇了社會偏見(Zou & Schiebinger,2018)。僅只聚焦技術編程和運算方法的電腦課程,無法讓學生了解電腦運算如何影響法律、政府、經濟和文化系統(Ko et al.,2020)。若能在核心CS 課程中融入交織性分析,就可以提高學生的批判性技能,以識別技術造成了系統性的不公義,並為未來的科學勞動力做更好的準備。

方法:交織性研究方法

重新思考諸如「技術」、「工程」和「編程」等概念,可以幫助學生認識電腦運算技術所引發的道德、社會和政治議題也是電腦科學的一部分,值得他們關注。運算決策是承載著價值判斷的,會對不同的社會群體產生影響。無論研究者是否認知到這些影響,事實都是如此。當現有的價值觀獲得關注,研究者和學生就有機會反思、挑戰並改變它們。

性別化創新:

- 1. 電腦運算研究生態系統之再造:負責任的電腦運算(responsible computing)已成為歐盟、美國和其他地方優先考慮的事項。通過將交織性分析整合進入補助申請、同儕審查流程以及公司審計中,同時透過鼓勵技術專家、人道主義者以及社會科學家之間的跨領域合作關係,即可鼓勵負責任的電腦運算生態系統。

- 2. 新興的CS課程:自2017年以來,大學持續在開發「嵌入式的CS倫理」(Embedded EthiCS),將交織性社會文化分析整合入核心CS課程中。本案例研究重點介紹了其中若干新興課程。

- 3. 課程內容中的包容性語言和視覺化:為了使工程和CS更能吸引傳統上代表性不足的群體,現已投入許多共同的努力。其中一個關鍵方法側重於打破刻板印象(National Academy of Engineering,2008)。

議題

交織性創新1:電腦運算研究生態系統之再造

交織性創新2:新興的CS課程

方法:交織性研究方法

性別化創新 3:課程內容中的包容性語言和視覺化

方法:重新思考語言和視覺表徵

結論和下一步

議題

電腦運算科學(computer science,CS)教育通常會磨練數學和工程技能,而忽略了道德、社會和政治的思辨。正如我們近年來所見,這樣的課程可能會致使社會不平等的擴張。例如,谷歌翻譯,將新聞從西班牙文譯成英文時,經常預設使用陽性代詞,從而强化「活躍的知識分子大都是男人」這樣的概念。同樣的,因詞向量(word embedding)的關係,典型歐裔美國人會與令人愉快的名稱連結起來,非裔美國人會與令人不愉快的連結起來,這再度加劇了社會偏見(Zou & Schiebinger,2018)。僅只聚焦技術編程和運算方法的電腦課程,無法讓學生了解電腦運算如何影響法律、政府、經濟和文化系統(Ko et al.,2020)。若能在核心CS 課程中融入交織性分析,就可以提高學生的批判性技能,以識別技術造成了系統性的不公義,並為未來的科學勞動力做更好的準備。

交織性創新1:電腦運算研究生態系統之再造

促進負責任的電腦運算已成為歐盟、美國和其他地方先考慮的事項(EU,2019)。美國國家科學院強調,「隨著運算技術日漸融入我們的社會和基礎設施,運算研究社群必須能夠處理這些技術的發展可能帶來的倫理和社會挑戰,從個人隱私的削弱到假訊息的傳播」(National Academies,2022)。電腦研究人員必須從一開始就預見社會風險。若未能在研究早期考慮社會、政治和經濟面向,可能會導致傷害。

政策是技術的驅動力之一,可以催化結構性的解決方案促進社會平等和環境永續性。這需要透過多種方式重新塑造電腦運算研究的生態系統:

1) 研究補助機構可以重新安排補助流程,以支持技術專家及人文專家學者/社會科學家之間的跨領域合作,這些領域通常在補助機構的不同部門中是孤立的。補助資金可以激勵新的研究夥伴關係(National Academies,2022)。審查申請案需要同時考慮該提案的技術卓越性和社會效益,並特別留意社會性別、種族以及交織性的社會分析。例如,史丹佛大學以人為本人工智慧研究中心(Human-Centered AI Institute at Stanford University)要求由技術專家小組以及人文專家學者和社會科學家小組審查研究提案。透過實施這些政策,研究機構協助培養的研究,能夠提高社會效益並且最大程度地降低對整個社會的危害。

2) 同儕審查期刊和研討會的編輯委員會可藉著在篩選發表論文時,要求進行縝密且批判性的生理性別、社會性別、種族、交織性以及社會分析來進一步支持這些努力。例如,神經資訊處理系統(Neural Information Processing Systems,NeurIPS)大會在採用論文前,會進行倫理審查(Bengio et al.,2021)。《自然》和《刺胳針》等期刊要求相關的研究進行生理性別和社會性別分析(Gendered Innovations,2022)。

3) 大學和研究機構可以將生理性別、社會性別、種族和更廣泛的交織性社會分析的知識整合入核心的工程、設計和電腦科學課程中。許多大學在人文和社會科學領域開設了關於這些主題的獨立課程。其重要性在於能夠使該領域的學生做好合作準備,但我們還需要將批判性的社會分析融入自然科學、電腦科學、醫學和工程學的核心課程中。

4) 產業。許多公司推廣的人工智慧原則(AI Principles)類似於2017年亞斯洛馬研討會(Asilomar Conference)所闡述的(Future of Life Institute,2017)。調查和審核公司針對社會性別、種族和交織性分析的原則和政策非常重要。產業可以透過僱用經過培訓的員工在跨領域團隊中工作以促進實現這些AI原則,這組跨領域團隊囊括技術專家、人文專家學者、社會科學家以及其他具備評估公司之產品、服務和基礎設施對於社會的潛在效益與危害的專業人員。

本案例研究聚焦於大學的培訓,因為大學培訓的是未來的勞動力。批判的交織性社會分析必須成為自然科學和工程核心課程的一部分。醫學方面也有類似的改進,例如德國柏林的夏綠特大學醫院(Charité University Hospital)從早期基礎科學到後期臨床模組的整個六年醫學訓練中,成功地融入了生理性別和社會性別分析(Ludwig et al.,2015)。(這些不是專業倫理的素材;它們是有關健康和醫學中的生理性別/社會性別分析的素材。)然而,這是個罕見的例子,大學必須做更多,為培養未來的科學勞動力。

交織性創新2:新興的CS課程

2017年以來,大學持續在開發哈佛大學首先提出的「嵌入式的CS倫理」(Embedded EthiCS),將倫理論證整合進入核心CS課程(Grosz et al.,2019;Garrett et al.,2020)。在許多其他的名稱之中,這些措施也被稱為「負責任的電腦運算」。我們建議融入交織性社會文化分析,從人文和社會科學中廣泛吸取技能。我們重點介紹了一些新興課程:

- 嵌入式的CS倫理(哈佛大學):2017年起,Barbara Grosz教授及其CS團隊與Alison Simmons教授以及哲學系開發合作,教導CS學生如何考慮他們工作的倫理和社會影響。嵌入式倫理直接將倫理引入標準CS課程(Grosz et al.,2019)。觀看他們的影片。

嵌入式CS倫理教授諸如應用於氣候變化、雲端安全、系統設計的性能與正確性的「責任」;有關軟體的驗證和確認、電子隱私和大數據系統、追蹤審查(tracking censorship)的「權利」;應用於演算法公正和再犯預測(recidivism prediction)、歧視和機器學習的「公正」;適用於 ASCII、Unicode和自然語言表達倫理的「平等」;有關軟體中詞向量的偏見和刻板印象造成的「歧視」等更多概念(見圖片)。可在此處查閱倫理模組課程。

- 嵌入式的CS倫理(史丹佛大學):2020年,史丹佛啟動了一項嵌入式倫理計畫,將聚焦倫理的講座、指派作業和評估納入核心CS課程。該計畫源於電腦科學系、麥考伊家庭社會倫理中心(McCoy Family Center for Ethics in Society)和以人為本的人工智慧研究所(Institute for Human-Centered Artificial Intelligence)之間的合作(Miller,2020)。

這個目標是開發直接與技術課程內容相關的倫理課程教材。例如,入門級的編程課程包含一場講座和作業,它們探討的議題是資料內涵的偏見,這些會傷害資料的代表性和配置(allocation)。另一項入門課程用洛杉磯的住房分配作為範例,討論了將資料用於處理排隊等候住房的倫理。此外,一門關於演算法的課程則討論了如果把現實世界的問題制式化,好讓演算法容易處理,這會造成怎樣的潛在影響。包括,如果在制訂時著重一個最佳化函數(optimization function),就可能使其他重要價值變得不見了。

- Mozilla負責任的電腦運算教學操作手冊,概述了特殊的方式營造了成功的、制度上永續的(institutionally sustainable),並且對學生進入勞動力市場有幫助的課程。負責任的電腦運算被寬鬆地定義為「電腦運算產品的設計需要將對社會的考慮納入」。Mozilla強調跨領域合作的必要性:「哲學家提出隱私的本質以及我們為何重視它的問題;政治學家提出科技如何影響政治制度的問題;批判的種族理論家研究科技如何再製並強化制度性的種族歧視;心理學家思考的是科技如何塑造我們的思維和行為方式;障礙研究分析障礙使用者如何「破解」現有科技,使其可為障礙者使用。出於這些原因,將其他學科的觀點、概念和工具與負責任的電腦運算工作進行對話,可強而有力地促進教學和研究」(Little et al.,2021)。

- 不可能的計畫以及負責任的電腦運算教學(紐約州立大學水牛城分校)包括重新設計第一年的討論課程,其中包含了專門針對運算的批判性方法的課程作業,(例如,講座投影片、指定作業、重新闡述的活動)。該課程的結訓是一場由學生根據主題(例如,反種族歧視運算,或者是數據驅動的犯罪風險評估中的偏見)提出解決方案的競賽。

- 負責任的電腦運算夥伴(科羅拉多大學博德分校):校園內的本科生申請一項獎學金計畫,該計畫涉及針對時事和技術倫理議題的研討式討論。學生也與客座講者一起參加活動,並有一個同儕社群來討論有關負責任的運算、就業、課程作業等的問題。

- 負責任的問題解決(布朗大學、哈弗福德學院、猶他大學)包括與負責任運算相關的資料結構和演算法主題的投影片、指定作業、講師筆記和資料集樣本(Cohen et al.,2021)。

- 透過角色扮演將倫理規範融入CS課程(喬治亞理工學院)包括具有書面場景、角色描述、補充閱讀材料的課程組成,以及與大學招生中的自動駕駛巴士和AI應用相關的活動教學指南。

- 電腦運算的社會和倫理責任(MIT)正在促進從事創造和設置運算技術的人員養成負責任的「思考和行動習慣」。

- 嵌入式倫理(喬治城大學)將倫理實驗室的哲學家和設計師與跨領域的教師相互搭配,共同設計倫理討論,並在他們的課程作業中進行訂製的、創造性的練習。學生將接觸到關鍵的道德概念和框架,並有機會辯論、應用並將特定背景的課程內化,以發展基本技能並實際地了解其潛在影響。與電腦科學系的合作關係於2019年啟動。

- 電腦運算的敘述:具有多種敘述形式的網站,能夠支持將倫理內容納入電腦科學課程。

人們也應該認知到,決定由誰來呈現這些內容也很重要:引入其他學科的外部專家有助於驗證社會分析的重要性。但是,CS教師親自教授這些內容也相當重要,如此可向學生表明其重要與相關性。

方法:交織性研究方法

重新思考諸如「技術」、「工程」和「編程」等概念,可以幫助學生認識電腦運算技術引發的道德、社會和政治問題也是電腦科學的一部分,並值得他們關注。運算決策是承載價值的,會對不同的社會群體產生影響。無論研究者是否認知到這些影響,事實都是如此。當現有的價值被挑明了,研究者和學生就有機會反思、挑戰並改變它們。

交織性創新3:課程內容中的包容性語言和視覺化

為了使工程和CS更能吸引傳統上代表性不足的群體,現已投入許多共同的努力。其中一個關鍵方法側重於打破刻板印象(National Academy of Engineering,2008)。

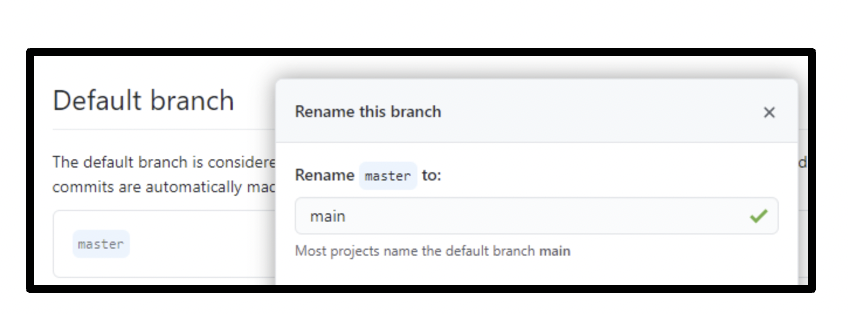

除了增加代表性不足群體的人數外,改變課堂教學和互動的內容及方法也很重要。電腦科學中的許多概念,都依賴於強化歷史不平等的語言。諸如以「master(主人)」和「slaves(奴隸)」之類的詞彙描述分散式系統中的伺服器架構(圖1)或使用「簡單到連你媽媽都能做!」作為使用者體驗基準,這些實例。

圖1:GitHub是提供版本控制的軟體開發程式碼代管服務。在過去,新的程式碼儲存庫的第一個分支被命名為「master(主人)」分支。然而,Git計畫與軟體自由保護組織(Software Freedom Conservancy)之間的對話導致GitHub內部的變革,而重新將儲存庫的預設分支命名為「main(主要)」。

同樣的,許多效能測試圖像,例如萊娜(Lena,自1973年以來電腦視覺領域的標準測試用圖像)也存在問題。萊娜是從1972年11月號的《花花公子》雜誌剪下來的一張瑞典模特兒Lena Forsén的照片。該圖不僅涉及生理性別歧視,還將「白皮膚」作為圖像處理的標準,導致人臉辨識與其他程序和程式出現諸多問題(Buolamwini & Gebru,2018)。重新思考語言和視覺表徵是一種相對簡單的介入措施,可以開始挑戰課堂上不平等的常規。

方法:重新思考語言和視覺表徵

重新思考語言和視覺表徵可以消除可能限制創新和發現的假設。在課堂上使用包容性語言有可能幫助來自不同背景的學生,使他們感到更自在和受到重視。

參考資料

AI Principles. (2017). Future of Life Institute. Retrieved October 18, 2022, from https://futureoflife.org/open-letter/ai-principles/

Bengio, S., Beygelzimer, A., Crawford, K., Fromer, J., Gabriel, I., Lewandowski, A., Raji, D., & Ranzato, M. (2021, August 23). NeurIPS 2021 Ethics Guidelines. Neural Information Processing Systems Blog. https://blog.neurips.cc/2021/08/23/neurips-2021-ethics-guidelines

Buolamwini, J., & Gebru, T. (2018). Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification. Proceedings of the 1st Conference on Fairness, Accountability and Transparency, 77–91. https://proceedings.mlr.press/v81/buolamwini18a.html

Cohen, L., Precel, H., Triedman, H., & Fisler, K. (2021). A New Model for Weaving Responsible Computing Into Courses Across the CS Curriculum. Proceedings of the 52nd ACM Technical Symposium on Computer Science Education, 858–864. https://doi.org/10.1145/3408877.3432456

European Union. (2019). EU guidelines on ethics in artificial intelligence: Context and implementation (European Parliament). https://www.europarl.europa.eu/RegData/etudes/BRIE/2019/640163/EPRS_BRI(2019)

640163_EN.pdfFiesler, C., Garrett, N., & Beard, N. (2020). What Do We Teach When We Teach Tech Ethics? A Syllabi Analysis. Proceedings of the 51st ACM Technical Symposium on Computer Science Education, 289–295. https://doi.org/10.1145/3328778.3366825

Garrett, N., Beard, N., & Fiesler, C. (2020). More Than “If Time Allows”: The Role of Ethics in AI Education. Proceedings of the AAAI/ACM Conference on AI, Ethics, and Society, 272–278. https://doi.org/10.1145/3375627.3375868

Gendered Innovations. (2022). Sex and Gender Analysis Policies of Peer-Reviewed Journals.

Grosz, B. J., Grant, D. G., Vredenburgh, K., Behrends, J., Hu, L., Simmons, A., & Waldo, J. (2019). Embedded EthiCS: Integrating ethics across CS education. Communications of the ACM, 62(8), 54–61. https://doi.org/10.1145/3330794">https://doi.org/10.1145/3330794">

https://doi.org/10.1145/3330794Horton, D., McIlraith, S. A., Wang, N., Majedi, M., McClure, E., & Wald, B. (2022). Embedding Ethics in Computer Science Courses: Does it Work? Proceedings of the 53rd ACM Technical Symposium on Computer Science Education V. 1, 481–487. https://doi.org/10.1145/3478431.3499407

Ko, A. J., Oleson, A., Ryan, N., Register, Y., Xie, B., Tari, M., Davidson, M., Druga, S., & Loksa, D. (2020). It is time for more critical CS education. Communications of the ACM, 63(11), 31–33. https://doi.org/10.1145/3424000

Little, M., Patterson, A., & Ricks, V. (2021). Working Across Disciplines (Teaching Responsible Computing Playbook). Mozilla Responsible Computer Science Challenge. https://foundation.mozilla.org/en/what-we-fund/awards/teaching-responsible-computing-playbook/topics/working-across-disciplines/

Ludwig, S., Oertelt-Prigione, S., Kurmeyer, C., Gross, M., Grüters-Kieslich, A., Regitz-Zagrosek, V., & Peters, H. (2015). A Successful Strategy to Integrate Sex and Gender Medicine into a Newly Developed Medical Curriculum. Journal of Women’s Health, 24(12), 996–1005. https://doi.org/10.1089/jwh.2015.5249

Miller, K. (2020, October 5). Building an Ethical Computational Mindset. Stanford Human-Centered Artificial Intelligence. https://hai.stanford.edu/news/building-ethical-computational-mindset

National Academies of Sciences, Engineering, and Medicine. (2022). Fostering Responsible Computing Research: Foundations and Practices. The National Academies Press. https://doi.org/10.17226/26507

National Academy of Engineering. (2008). Changing the Conversation: Messages for Improving Public Understanding of Engineering. The National Academies Press. https://doi.org/10.17226/12187

UN Office of the Secretary-General’s Envoy on Technology. (n.d.). Digital Human Rights.Retrieved October 18, 2022, from https://www.un.org/techenvoy/content/digital-human-rights

Zou, J., & Schiebinger, L. (2018). AI can be sexist and racist—It’s time to make it fair. Nature, 559(7714), 324–326. https://doi.org/10.1038/d41586-018-05707-8