臉部辨識:

分析機器學習中的社會性別與交織性

臉部辨識系統(FRSs)可用於在人群中辨認人、分析情緒,以及偵測社會性別、年齡、種族、性傾向、臉部特徵等等。這些系統常被運用於招募、授權付款、保全、監視以及手機解鎖。儘管學術界及業界的研究人員花費心力要提升其可靠性與穩固性,但近期的研究顯示,這些系統可能會基於如種族、社會性別等特性,以及特性間的交織關係而形成歧視(Buolamwini & Gebru, 2018)。

方法:分析機器學習當中的社會性別與交織性

機器學習(ML)的偏誤是多面向的,而且可能肇因於資料蒐集,或是資料準備與模型的挑選。舉例而言,一個由男性與淺色皮膚個體所組成的資料集將會有較高的機率誤認深膚色的女性。這是個交織性偏誤的案例。當中不同類型的歧視都會擴大對於個人或群體的負面影響。

性別化創新:

- 了解臉部辨識中的歧視。臉部辨識系統中的每個步驟——從臉孔偵測到臉部特徵分類、臉部驗證以及臉孔辨認——都應檢驗是否具有偏誤。為達到效果,模型訓練使用的資料集必須要能代表目標群體。舉例而言,以熟齡者訓練的模型在面對年輕人時的表現就不理想(Howard et al. 2017)。

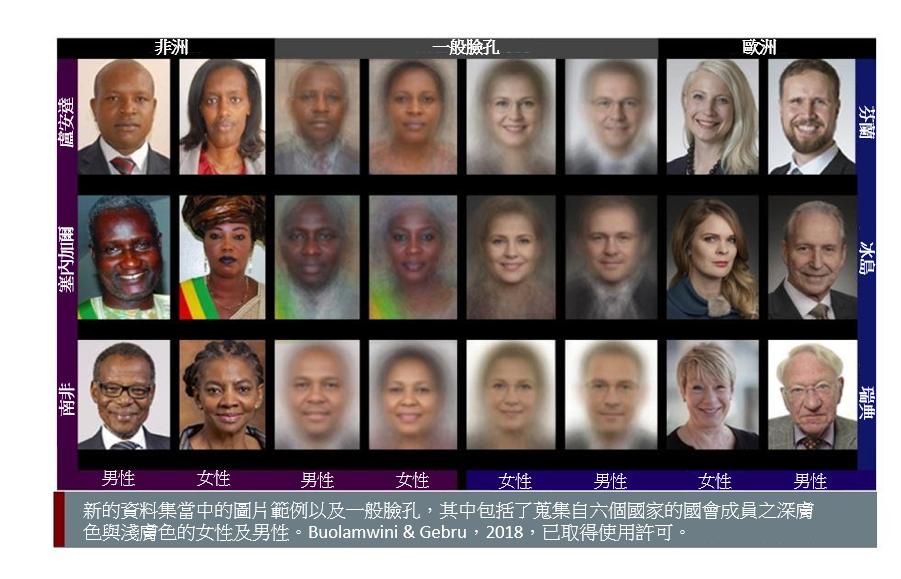

- 打造具交織性的訓練資料集。要能有效運用在例如驗證跨越國界者的身份等用途上,訓練資料集會需要包含具有交織性的特徵,例如社會性別及種族。來自麻省理工學院的「社會性別色調(Gender Shades)」企畫便以四種分類發展並驗證了這樣的訓練集:深膚色女性、深膚色男性、淺膚色女性及淺膚色男性(Buolamwini & Gebru, 2018)。

- 為多元臉孔集建立參數。使用化妝品會讓臉部辨識系統的準確性下降76%(Dantcheva et al., 2012; Chen et al., 2015)。跨性別者,特別是在性別轉換的期間,可能會被誤認(Keyes, 2018)。可供公開取用的臉孔資料集需要建立參數,以提升跨越多元類別之準確度(Eckert et al., 2013),且不會讓這些社群陷入危險(Keyes, 2018)。

議題

臉部辨識系統(FRSs)可用於在人群中辨識人、分析情緒,以及偵測社會性別、年齡、種族、性傾向、臉部特徵等等。這些系統被運用在許多領域中,例如聘僱、授權付款、保全、監視,以及解鎖手機。儘管學術界及業界的研究人員花費心力要提升其可靠性與穩固性,但近期的研究顯示,這些系統可能會基於如種族、社會性別等特性,以及特性間的交織關係而形成歧視(Buolamwini & Gebru, 2018)。相應地,國家政府、公司,以及學術研究人員對於臉部辨識的倫理與合法性有著許多辯論。其中一個重點是要加強此項科技的準確性與公平性;而另一個面向則是要評估其使用,並以謹慎執行的政策規範其運用。

方法:分析機器學習中的社會性別與交織性

機器學習(ML)的偏誤是多面向的,而且可能肇因於資料蒐集,或是資料準備與模型的挑選。在第一種狀況中,資料可能會含有人的偏誤。舉例而言,一個由男性與淺色皮膚個體所組成的資料集將會有較高的機率誤認深膚色的女性。這是個交織性偏誤的案例。當中不同類型的歧視都會擴大對於個人或群體的負面影響。交織性是指影響個人或群體身份、經歷和機會的交織類別,例如種族、年齡、社會經濟地位、性取向和地理位置。

偏誤也可能在資料準備及模型挑選的過程中被帶進來。此牽涉到挑選出演算法需要考量或忽略的特質,例如臉部化妝或是跨性別主體在性別轉換期間的臉孔。

性別化創新1:了解臉部辨識中的歧視

為了要了解臉部辨識系統中的歧視,先理解臉孔偵測、臉部特徵分類、臉部辨識、臉孔確認以及臉部識別之間的差異。

臉孔偵測可以在不做臉部辨識的狀況下進行;然而沒有臉孔偵測,臉部辨識便無法運作。臉孔偵測是在圖片或影片當中,將人臉從其他物品當中分辨出來。臉孔偵測系統不斷被測試出在面對膚色較深的個體時會失效(Buolamwini, 2017)。例如Google Photos早期所使用的數據化圖片標示演算法版本就將深色皮膚者分類為猩猩(Garcia, 2016)。一旦第一個步驟出了差錯,臉部辨識系統就會失靈。

臉部特徵分類會將臉部特徵進行標示,例如社會性別、年齡、族群、鬍鬚或帽子的有無,或甚至是情緒。以情緒而言,一份針對線上辨識應用程式界面(API)的回顧分析顯示,超過半數的系統使用臉部表情來定義情緒(Doerrfeld, 2015)。為達效果,這些模型必須要以具有目標群體代表性的資料集來進行訓練,像是使用成年人來訓練的模型在面對年輕人時的表現就會較不理想(Howard et al., 2017)。

臉部辨識是藉由將某人的圖片與其已知的臉部輪廓進行比對來辨識出特定的個體。臉部辨識的一種類型是用於驗證,經常被運用在解鎖手機或驗證跨越國界者的身份(參考歐盟補助之H2020計畫,iBorderCtrl)。這些應用的設計是為了要減少過程所需的時間。然而,若是臉部辨識系統的訓練不確實,例如面對到深膚色的女性(Buolamwini & Gebru, 2018)或是跨性別者(Keyes, 2018)的臉孔時,這項科技便無法有效服務這些人——詳見下方。另一類的臉部辨識是臉部識別,亦即將目標人物的臉與臉孔資料庫進行比對。這項技術常被用於失蹤人口或犯罪事件當中。

性別化創新2:打造具交織性的訓練資料集

臉部辨識系統的準確性取決於蒐集來進行測試使用的圖片或影片集。要讓臉部辨識系統表現準確,訓練集必須要足夠廣泛且多元,以便預測模型能夠在不同的脈絡中正確地辨識臉孔。

Zhao等人(2017)發現,在遇到男性身處廚房當中的照片時,自動化圖片標示演算法會系統化地將人物錯認為女性。一部分的原因就在於訓練集當中描繪女性下廚的脈絡比男性多出了33%。在測試當中,訓練模型強化此差異的程度從33%到68%不等。訓練資料的正確性因此至關重要。

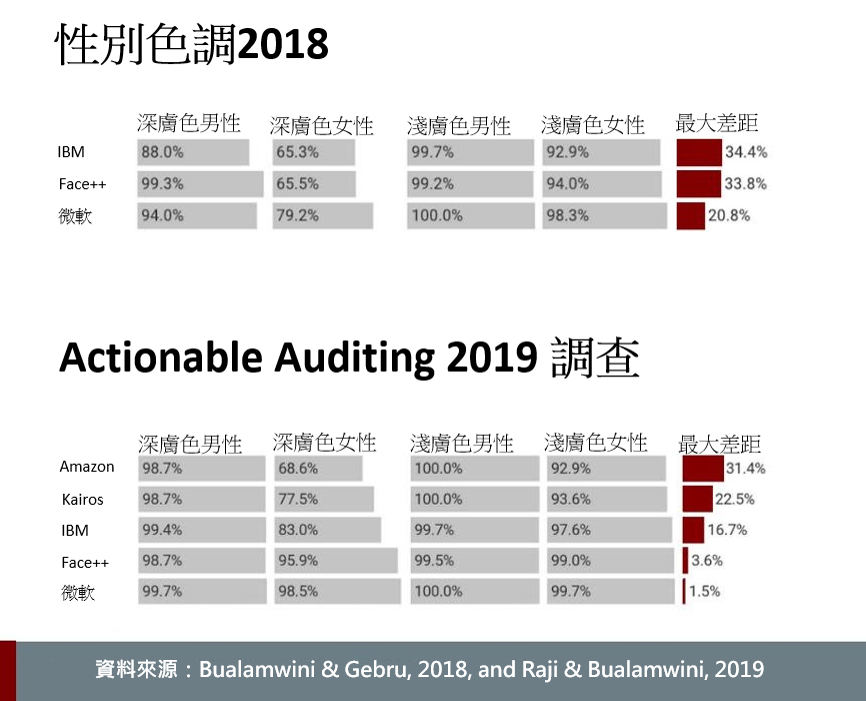

在現在廣為人知的社會性別色調(Gender Shades)研究中,Buolamwini & Gebru (2018)檢測了商業性的社會性別分類系統的準確性,包括微軟、IBM與Face++,他們發現膚色較深的女性經常被錯誤分類。各系統在男性臉孔的表現上都比女性臉孔較佳,且所有的系統在淺色皮膚上的表現也都比深色皮膚較好。錯誤率在深膚色女性是35%、深膚色男性是12%、淺膚色女性是7%,而淺膚色男性則是不到1%。

為了克服這些問題,團隊發展並標示了一個具交織性的資料集,以此測試四個子群組的社會性別與種族分類表現:深膚色女性、深膚色男性、淺膚色女性與淺膚色男性。由於種族與族裔標示是相當具有文化特定性的,團隊使用膚色色調來計算資料集的多元性(Cook et al., 2019)。其資料集中包含了1270張來自三個非洲國家(盧安達、塞內加爾、南非)及三個歐洲國家(冰島、芬蘭、瑞典)的圖片。

社會性別色調的更新針對先前檢驗的三個商業系統進行複檢,並擴大其回顧範圍,將Amazon的Rekognition以及來自一間名為Kairos之小型AI公司的新系統也納入其中。他們發現,IBM、Face++以及微軟在深膚色女性的社會性別分類準確度上全都有了提升,其中微軟更是將錯誤率降到了2%以下(Raji & Buolamwini, 2019)。然而Amazon與Kairos的平台在淺膚色男性與深膚色女性之間的準確率差距仍舊高達31%與23%。

IBM研究院最近發表了一個名為多元臉孔Diversity in Faces(DiF)的大型資料集。其目標是希望加強臉部辨識系統在公平性與準確性上的研究(IBM, DiF)。

性別化創新3:為多元臉孔集建立參數

化妝品

化妝一事無論是橫跨歷史或不同文化都相當時興。雖然男性也逐漸開始使用化妝品,然而女性化妝的情形還是較常見。Loegel等人(2017)研究表示,女性使用化妝來讓自己得以符合文化常規中的女性化形象。

臉部化妝品會導致商業用與學術用臉部辨識方式的準確性下降最高多達76.21%(Dantcheva et al., 2012; Chen et al., 2015)。原因之一就是化妝在公開取用的臉部資料庫中尚未建立其參數(Eckert et al., 2013)。針對臉部辨識系統在臉部化妝上的強化發展有一項提案是將同一個人有化妝及沒有化妝的多張圖片加以對照呼應。而這些解決方法同時也需要考量到不同文化的化妝習慣差異(Guo & Yan, 2014)。

跨性別

臉部辨識系統領域裡其中一個逐漸浮現的議題便是跨性別者的臉孔,特別是處於轉換過程的期間。Keyes(2018)發現,「自動化社會性別辨識Automatic Gender Recognition(AGR)」的研究忽略了跨性別者,且造成負面結果。舉例而言,一名跨性別的Uber司機因為臉部辨識安全設施無法確認其身份,而被要求得花費兩小時的交通時間前往當地的Uber辦公室。該公司使用的是微軟的Azure認知服務技術,藉由定期要求司機在開始上班之前回傳自拍照給Uber以減少詐騙的情形(Melendez, 2018)。

跨性別賀爾蒙療法會使臉部的脂肪重新分配,並且改變臉部整體的外型與質地。依據不同的轉換方向(例如男跨女,或女跨男),轉變後的臉孔最顯著的變化影響了細小的皺紋與線條、皮膚擴張紋、皮膚變厚或是變薄,以及質地的差異。例如雄性賀爾蒙療法就會使臉部變得更有稜角。

此問題的解決方法是否就是確保訓練資料當中涵括了大量的跨性別者,以便能藉此將偏誤改正呢?去除偏誤聽起來可能不錯,但是針對一個有理由對於提供資訊感到不舒服的社群進行資料蒐集,這可能不是個最好的方法(Keyes, 2018)。在這樣的情況下,修正演算法的參數可能就很重要。現存的方法顯示,在進行跨性別者的圖像辨識時,比起使用全臉,僅用眼睛(或眼周)的範圍更為可靠,因為眼周受到的改變比臉部其他區域的較少(Mahalingam et al., 2014)。

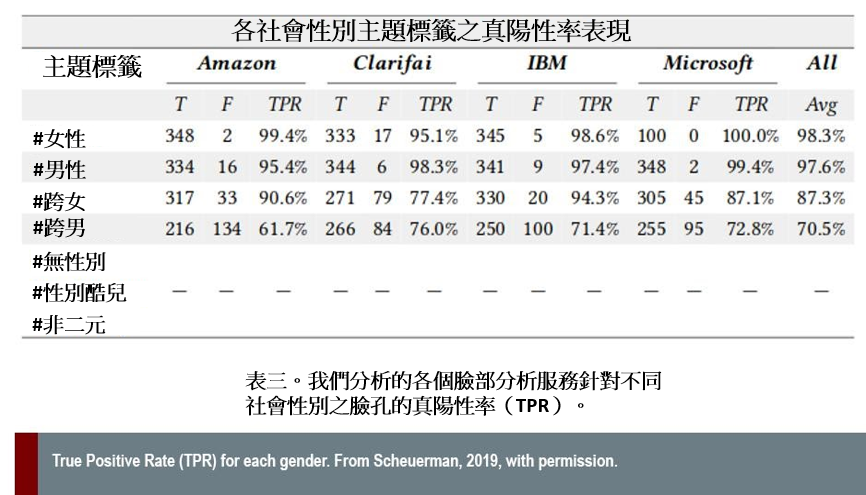

Scheuerman等人(2019)發現,四個商業性辨識服務(Amazon Rekognition, Clarifai, IBM Watson Visual Recognition 以及 Microsoft Azure)面對跨性別主體時的表現都很差,而且無法分類非二元性別。藉由使用主體在自己的Instagram貼文中提供的主題標籤(hashtag)(#女性、#男性、#跨女、#跨男、#無性別、#性別酷兒、#非二元),該團隊計算了其針對2450張圖像進行的社會性別分類結果的準確度。平均而言,各系統分類順性別女性(#女性)的準確度有98.3%,順性別男性(#男性)則有97.6%。面對跨性別者的準確度便下降了,面對#跨女的平均是87.3%,#跨男則是70.5%。而自我認同為#無性別、#性別酷兒,或是#非二元者則是100%都被錯誤分類了。

情緒

由歐盟所補助的SMART計畫(自動化辨識科技拓展措施Scalable Measures for Automated Recognition Technologies)旨在研究智慧監控能夠如何保護人民免於人身威脅,同時又能夠顧及其隱私。該計畫提出了一種同時利用了音訊和視訊資訊的多模式情緒識別系統。(Dobrišek et al., 2013)。此實驗性結果顯示,其性別辨識子系統讓整體的情緒辨識準確度從77.4%提升到了81.5%。

結論

臉部辨識系統會因為有意識或無意識地將人類的偏誤進行編碼而延續甚至強化社會不公的模式。了解潛藏在社會中的交織性歧視將有助研究人員發展出更為公義且負責任的科技。政策制定者也應確保生物識別之計畫在實施之前都有經過徹底且透明的公民權益評估。

臉部辨識潛在的濫用已經引發了好幾次的行動:比利時宣佈使用臉部辨識是違法的、法國與瑞典表示禁止此科技在學校當中使用,而加州洛杉磯則是禁止當地的機構使用此技術,例如交通單位或執法單位。許多公司也開始收手:IBM已經完全撤出臉部辨識的市場了,而Amazon為了回應2020年世界各地對於系統性種族不公的抗爭,亦停止讓警方使用其臉部辨識科技。

為了尋求長久的解決方法,美國演算法正義聯盟呼籲成立一個類似於美國食藥署的聯邦單位來規範臉部辨識(Learned-Miller et al., 2020)。

下一步

- 演算法的優劣取決於其使用的資料。訓練資料集應該要夠大夠多樣,以便支援臉部辨識系統面對多元的群體與多元的脈絡。

- 在美國國家標準技術研究院(NIST,2019)發布的臉部識別供應商測試中,1:N報告(與穿戴式攝影機使用的臉部辨識系統最為相關)內未包含針對種族、年齡和社會性別等因子的準確度指標之詳細分類。這點應加以修正。

- 發展公平、透明且值得信賴的臉部分析演算法。

- 許多研究與系統都仍採用了二元的社會性別觀點。此領域中的研究與創新應該要認知到為數眾多的性別多元主體之存在,並且打造出跨越整體社會都能適用的科技。

參考資料

Buolamwini, J., & Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. Proceedings of Machine Learning Research, 81, 77-91.http://gendershades.org

Buolamwini, J. (2017). Algorithms aren’t racist. Your skin is just too dark. Hackernoon. https://hackernoon.com/algorithms-arent-racist-your-skin-is-just-too-dark-4ed31a7304b8

CASIA WebFace Vision Dataset. Retrieved September 4, 2019, from http://pgram.com/dataset/casia-webface

Chen, C., Dantcheva, A., & Ross, A. (2015). An ensemble of patch-based subspaces for makeup-robust face recognition. Information fusion, 32(B), 80-92. https://www.cse.msu.edu/~rossarun/pubs/ChenEnsembleFaceMakeup_INFFUS2016.pdf

Cook, C. M., Howard, J. J., Sirotin, Y. B., Tipton, J. L., & Vemury, A. R. (2019). Demographic effects in facial recognition and their dependence on image acquisition: an evaluation of eleven commercial systems. IEEE Transactions on Biometrics, Behavior, and Identity Science, 1(1), 32-41.

Dantcheva, A., Chen, C., & Ross, A. (2012). Can facial cosmetics affect the matching accuracy of face recognition systems? 2012 IEEE Fifth International Conference on Biometrics: Theory, Applications and Systems (BTAS), (pp. 391-398). IEEE. https://ieeexplore.ieee.org/document/6374605/

Dobrišek, S., Gajšek, R., Mihelič, F., Pavešić, N., & Štruc, V. (2013). Towards efficient multi-modal emotion recognition. International Journal of Advanced Robotic Systems, 10(1), 53. https://journals.sagepub.com/doi/10.5772/54002

Doerrfeld, B. (2015). 20+ Emotion recognition APIs that will leave you impressed, and concerned. Nordic APIs Blog. https://nordicapis.com/20-emotion-recognition-apis-that-will-leave-you-impressed-and-concerned/

Eckert, M. L., Kose, N., & Dugelay, J. L. (2013). Facial cosmetics database and impact analysis on automatic face recognition. 2013 IEEE 15th International Workshop on Multimedia Signal Processing (MMSP) (pp. 434-439). IEEE.https://ieeexplore.ieee.org/abstract/document/6659328

Garcia, M. (2016). Racist in the machine: the disturbing implications of algorithmic bias. World Policy Journal, 33(4), 111-117.

Guo, G., Wen, L., Yan, S. (2014). Face authentication with makeup changes. IEEE Transactions on Circuits and Systems for Video Technology, 24(5), 814-825.

Howard, A., Zhang, C., & Horvitz, E. (2017). Addressing bias in machine learning algorithms: a pilot study on emotion recognition for intelligent systems. 2017 IEEE Workshop on Advanced Robotics and Its Social Impacts (ARSO). 10.1109/ARSO.2017.8025197

IBM Diversity in Faces. Retrieved 4 September, 2019, from https://www.research.ibm.com/artificial-intelligence/trusted-ai/diversity-in-faces/

iBorderCtrl Project. Retrieved 4 September, 2019, from https://www.iborderctrl.eu.

Keyes, O. (2018). The misgendering machines: trans/HCI implications of automatic gender recognition. Proceedings of the ACM on Human-Computer Interaction, 2 (CSCW). https://doi.org/10.1145/3274357

Labeled Faces in the Wild. University of Massachusetts, Amherst. Retrieved 4 September, 2019, from http://vis-www.cs.umass.edu/lfw/

Learned-Miller, E., Ordóñez, V., Morgenstern, J., & Joy Buolamwini, J. (2020). Facial Recognition Technologies in the Wild. https://global-uploads.webflow.com/5e027ca188c99e3515b404b7/5ed1145952bc185203f3d009_FRTsFederalOfficeMay2020.pdf. Accessed 11 June 2020.

Liu, Z., Luo, P., Wang, X., & Tang, X. CelebFaces Attributes (CelebA) Dataset. Retrieved 4 September, 2019, from http://mmlab.ie.cuhk.edu.hk/projects/CelebA.html

Loegel, A., Courrèges, S., Morizot, F., & Fontayne, P. (2017). Makeup, an essential tool to manage social expectations surrounding femininity? Movement and Sports Sciences, 96 (2), 19-25. https://www.cairn.info/revue-movement-and-sport-sciences-2017-2-page-19.htm

Mahalingam, G., Ricanek, K., & Albert, A. M. (2014). Investigating the periocular-based face recognition across gender transformation. IEEE Transactions on Information Forensics and Security, 9(12), 2180-2192.

Melendez, S. (2018, August 9). Uber driver troubles raise concerns about transgender face recognition. Fast Company. Retrieved 24 July, 2019, from https://www.fastcompany.com/90216258/uber-face-recognition-tool-has-locked-out-some-transgender-drivers

National Institute of Standards and Technology (NIST). (2019). FRVT 1:N Identification. U.S. Department of Commerce. Retrieved 4 September, 2019, from https://www.nist.gov/programs-projects/frvt-1n-identification

Raji, I. D., & Buolamwini, J. (2019). Actionable auditing: investigating the impact of publicly naming biased performance results of commercial AI products. Proceedings of the AAAI/ACM Conference on Artificial Intelligence, Ethics, and Society. https://www.media.mit.edu/publications/actionable-auditing-investigating-the-impact-of-publicly-naming-biased-performance-results-of-commercial-ai-products/

Scalable measures for automated recognition technologies (SMART) project. CORDIS. Retrieved 4 September, 2019, from https://cordis.europa.eu/project/rcn/99234/factsheet/en

Scheuerman, M. K., Paul, J. M., & Brubaker, J. (2019). How computers see gender: an evaluation of gender classification in commercial facial analysis and image labeling services. In Proceedings of the ACM on Human-Computer Interaction, 3(CSCW). https://docs.wixstatic.com/ugd/eb2cd9_963fbde2284f4a72b33ea2ad295fa6d3.pdf

Surfshark. Retrieved 15 June, 2020, from https://surfshark.com/facial-recognition-map

VGGFace2. Retrieved 4 September, 2019, from http://www.robots.ox.ac.uk/~vgg/data/vgg_face2/

Zhao, J., Wang, T., Yatskar, M., Ordonez, V., & Chang, K. W. (2017). Men also like shopping: reducing gender bias amplification using corpus-level constraints. arXiv Preprint. https://arxiv.org/abs/1707.09457

臉部識別系統可以識別人群中的人、分析情緒並檢測性別、年齡、種族、性取向等。這些系統常被運用於招聘、授權付款,安全,監視和解鎖手機。但是,這些系統也可能因為如種族、性別及其交織而成的種種特徵而形成歧視。本案例研究著眼於克服這種偏見的方法。 1.社會性別。一個研究小組發現,當照片描繪出廚房裡的男人時,自動圖片標示演算法會系統性地將圖中人物誤認為女性。為什麼?部分原因在於訓練集當中描繪女性下廚的脈絡比男性多出了33%。 修正方法:重新配置訓練資料。 2.性別與種族的交織。一項著名的研究「社會性別色調」(Gender Shades)測量了Microsoft、IBM和Face ++的商業性別分類系統的準確性。研究發現,膚色較深的女性經常被錯誤分類。有幾個系統在男性臉孔上的表現比在女性臉孔上更為優良,而所有系統在淺膚色上的表現都比深膚色上更好。深膚色女性的錯誤率為35%、深膚色男性為12%、淺膚色女性為7%、淺膚色男性則小於1%。 修正方法:團隊為四個子群體開發並標記了一個新的交織性資料集:深膚色女性,深膚色男性,淺膚色女性和淺膚色男性。此資料集包含了來自三個非洲國家(盧安達、塞內加爾和南非)和三個歐洲國家(冰島、芬蘭和瑞典)的1270張圖像。使用了這個新的資料集,各商業系統的準確性都有了提升。

3.化妝。化妝會讓商業性及學術性臉部辨識方法的準確度皆下降高達76%!原因之一是公開可得的臉部資料庫尚未建立一個化妝的參數。 修正方法:有一項提案是將同一個人有化妝及沒有化妝的多張圖片加以對照呼應。而這些解決方法同時也需要考量到不同文化的化妝習慣差異。

4.跨性別:臉部辨識系統領域裡其中一個逐漸浮現的議題便是跨性別者的臉孔,特別是處於轉換過程的期間。性別確認賀爾蒙療法會使臉部的脂肪重新分配,並且改變臉部整體的外型與質地。 修正方法:在此情況下,修正演算法的參數改為仰賴眼睛(或眼周)區域是很重要的。但是跨性別社群也警告了,向一個處於危險當中的社群進行資料蒐集並不是最好的作法。

臉部辨識系統會因為有意識或無意識地將人類的偏誤進行編碼,而延續甚至強化社會不公的模式。了解潛藏在社會中的交織性歧視將有助研究人員發展出更為公義且負責任的科技。政策制定者也應確保生物識別之計畫在實施之前都有經過徹底且透明的公民權益評估。