性別化社交機器人:分析社會性別

議題

人類常會將機器人視為人來對待,對機械投射人類性格,例如個人特質和意向性。人類也會投射社會性別在機器人上,包括了對「雄性」與「雌性」實體該如何表現的期望。

方法:分析社交機器人的社會性別與交織性

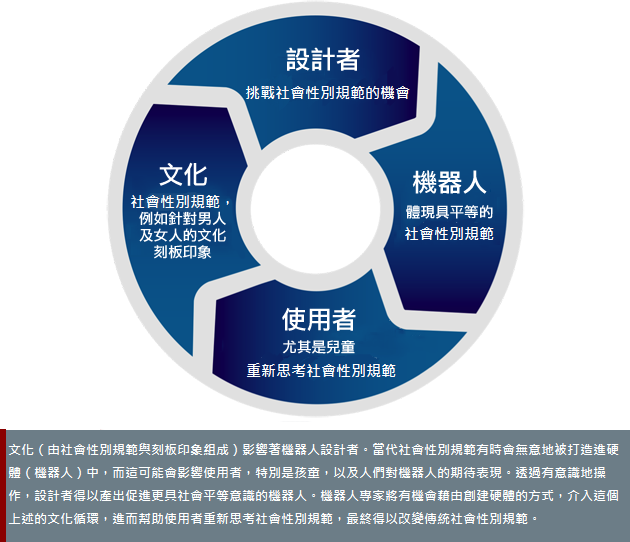

機器人是在一個活躍著社會性別常模、社會性別認同與社會性別關係的世界中被設計出來的。人類——無論是設計者或使用者,常會將機器性別化(因為在人類文化中,社會性別是個主要的社會分類)。這樣的性別化該被推廣嗎?將機器人性別化能提高人類的接受度嗎?這能優化人類與機器人合作時的表現嗎?或者將機器人性別化應該受到抵制?這會強化性別刻板印象,擴大社會上的不平等嗎?其中的危險在於,迎合當前的刻板印象來設計硬體可能會強化這些刻板印象。設計者的挑戰是加以瞭解性別是如何被體現在機器人身上的,以便設計出有助社會平等的機器人。

性別化創新:

1. 瞭解社會性別是如何被體現在機器人上

2. 設計有助社會平等的機器人

議題

性別化創新1:瞭解社會性別是如何被體現在機器人上

性別化創新2:機器人是否能被設計來促進社會平等

方法:構想研究問題

結論

下一步

議題

直至近期,機器人大多仍僅限在工廠內使用。大多數的人從未見過機器人,亦不曾跟它們互動,且機器人的外觀、聲音或行為也都不像人類。但工程師逐漸開始設計能夠與人互動的機器人─服務型機器人。它們會出現在醫院、老年照護機構、教室、家庭、機場,以及飯店—而這將是本篇案例分析的焦點。雖然,機器人也被研發用於戰爭、警察執法、拆彈、保全,以及性產業上—但這些主題並非我們所要討論的內容。

女性、男性以及多元性別個體可能會有不同的需求或社交偏好,設計者們應當以性別包容的設計作為目標(Wang, 2014)。社會性別包容設計並非「社會性別盲」或「社會性別刻板印象」,而是考量到特定社會群體的需求時所做的設計。

機器人的設計者以及人機社交互動專家(sHRI)認為,若我們將人類的社交線索—包括社會性別—投射在人工媒介上,將能幫助使用者更有效地與機器人產生連結(Simmons et al., 2011; Makatchev et al., 2013; Jung et al., 2016)。然而,一旦在使用者為機器指定了社會性別之後,刻板印象便隨之而來。機器人與人工智慧的設計者不只是創造出反映社會的產品而已,他們(或許是無意地)也再次強化及認可了某些社會性別常規,特別是對於女性、男性或多元性別主體的社會性別規範(例如,社交態度與行為)。

人類如何將社交機器人「性別化」的?為打造更具平等的性別規範,機器人是否可提供新契機?我們能如何將具社會責任的機器人設計到最好?

性別化創新1:瞭解社會性別是如何被體現在機器人上

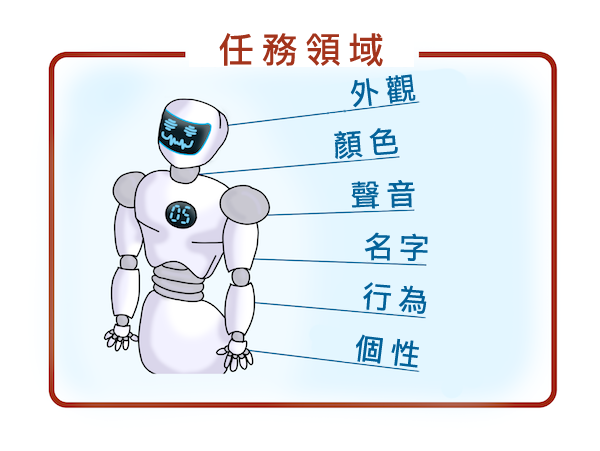

社會性別線索可能以許多方式體現在社交機器人上(Kittmann et al., 2015)。即使是一個單一且簡單的社會性別線索也可能引發人們對於符合此行為的規範性期待,以及社會性別詮釋。下列圖片顯示機器人設計中可能隱含社會性別線索的多種面向—詳細說明請點擊圖片連結查看。

在人類社會中,有許多任務與分工由特定社會性別掌控,例如:某些事務由女人或男人所支配。舉例而言,家務勞動、醫療照護經常被視為專屬女性的事務,在此「女性」機器人可能會有最好的表現,因為它符合人類期待。相反地,保全或數學家教則被認為屬於男性領域,因此,使用者可能偏好採用「男性」機器人。

這種「符合期待」的預設假說會反映在機器人的外觀與其在互動過程中擔任的角色上。換句話說,機器人的外表能夠影響人們是否遵循機器人指示的意願,以及人機互動的成功(Nass & Moon, 2000; Goetz et al., 2003; Carpenter et al., 2009; Eyssel & Hegel, 2012; Otterbacher & Talias, 2017, but see Kuchenbrandt et al., 2012, Rea et al., 2015, Reich-Stiebert & Eyssel, 2017)。以醫療照護為例,當與上圖敘述中的機器人互動時,它如何考量病患的社會性別、年齡、教育程度等面向便相當重要。

雖然讓機器人的表現「符合」人類的期待可能會增加接受度,但風險在於─讓機器人的社會性別與刻板印象相吻合,將會更加強化人類社會中的社會性別分工及隔離。舉例來說,將機器人「女性化」,讓它從事看似屬於女人的工作—通常為薪資低的工作—可能會加深社會的不平等現象。而男性化的接待型或護理型機器人或許能挑戰現存的社會性別刻板印象,同時鼓勵對於人類男性擔任照護角色的接受度。

方法:構想研究問題

機器人該如何設計,才能同時確保使用者的高接受度又能推廣社會平等呢? 我們至少有以下六種選擇:

1. 挑戰現存的社會性別刻板印象

2. 設計「客製化機器人」,讓使用者得以選擇特徵

3. 設計「無社會性別」機器人

4. 設計「性別流動」的機器人,優先考量性別平等

5. 遠離人類社交關係

6. 設計「專屬機器人」的認同,避免複製社會刻板印象

在機器人的社會性別議題上,機器人學家有許多選擇可以考量。

1. 挑戰現存的社會性別刻板印象

眾所皆知,人機互動是以類似人與人的互動之方式進行的。然而,機器設計過程中,若將刻板印象建置於硬體中,此舉將會複製刻板印象,並且讓現存的社會不平等現象繼續進行(Eyssel & Hegel, 2012)。而設計出具社會性別刻板印象的機器人,可能會:1)擴大性別不平等;2)冒犯他人;3)導致市場失利。

美國太空總署的超級英雄救援機器人「女武神」(Valkyrie)就挑戰了社會性別刻板印象。雖然美國太空總署官方聲稱「女武神」是社會性別中立的,但設計者仍刻意地將她打造成超級女英雄的形態(高187公分,重129公斤),藉此激勵他當時7歲的女兒。女武神完成時便配有胸部及女性的名字(Valkyrie為北歐神話中的女神人物)。為了打造她的外型,設計團隊邀請了一位由物理學家轉職時裝界的法國設計師一同協助設計(Dattaro,

2015)。雖然女武神的部分表現反映出陽剛特質,例如與鋼鐵人相近的視覺線索,但在這領域中有一位女性代表仍相當有趣。

美國太空總署的超級英雄救援機器人「女武神」(Valkyrie)就挑戰了社會性別刻板印象。雖然美國太空總署官方聲稱「女武神」是社會性別中立的,但設計者仍刻意地將她打造成超級女英雄的形態(高187公分,重129公斤),藉此激勵他當時7歲的女兒。女武神完成時便配有胸部及女性的名字(Valkyrie為北歐神話中的女神人物)。為了打造她的外型,設計團隊邀請了一位由物理學家轉職時裝界的法國設計師一同協助設計(Dattaro,

2015)。雖然女武神的部分表現反映出陽剛特質,例如與鋼鐵人相近的視覺線索,但在這領域中有一位女性代表仍相當有趣。

社會性別線索可能相當隱晦。軟銀(SoftBank)將其研發生產的機器人「Pepper」以男性的「他」(he)稱呼,雖然機器人緊縮的腰部和裙狀的下肢看來是女性化的。軟銀宣傳時稱Pepper是「第一個能夠辨認人類主要情緒,並依照對話者的心情調整自身行為的人形機器人。」而情緒議題常被認為是屬於女性職掌的範疇;在這個例子中,機器人製作者反轉了文化刻板印象,將Pepper性別化為男性。

社會性別線索可能相當隱晦。軟銀(SoftBank)將其研發生產的機器人「Pepper」以男性的「他」(he)稱呼,雖然機器人緊縮的腰部和裙狀的下肢看來是女性化的。軟銀宣傳時稱Pepper是「第一個能夠辨認人類主要情緒,並依照對話者的心情調整自身行為的人形機器人。」而情緒議題常被認為是屬於女性職掌的範疇;在這個例子中,機器人製作者反轉了文化刻板印象,將Pepper性別化為男性。

2. 「客製化機器人」設計

當設計者決定打造「類人機器人」時,有一個選項是讓使用者能夠參與設計過程,並客製化社會性別線索。行程安排機器人「x.ai」的設計者提供客戶命名的選擇:艾咪(Amy)或安德魯(Andrew)。雖然名字帶有社會性別意涵,但其聲音都是一樣的音頻,設計者認為此目的是「對抗社會性別刻板印象」。上述設計公司提出聲明表示:「我們的目標是提供客戶選擇智能助手姓名的選擇,此外也同時確保所有的用詞都是社會性別中立且貼近事實現狀,如時間、地點與位置等,並非在閒聊中形成」(Conren, 2017)。然而,「艾咪Amy、安德魯Andrew」這兩個名字明顯來自白人種族與英語系的國家預設。在種族議題上,不太會有「伊曼妮(Imani)」或「賈莫(Jamal)」(阿拉伯語)的命名選項提供給客戶參考。此外,性別流動者也可能會希望有超越性別二元的選項能選擇。

Savioke公司的服務型機器人Relay則是個有趣的例子。在跳脫一般思維的邏輯上,它是社會性別中立的,例如配戴著由粉紅色漸層至藍色的顯示器。雖然Relay不會說話,但設計團隊積極宣傳Relay的特質─迷人、有禮貌和誠實,它是一位「智能管家(Botlr)」,(Botlr一詞由英文的「管家(butler)」變化而來)。Relay的頭頂能夠開啟,用來為飯店顧客遞送毛巾、報紙及其他服務物品。雖然Savioke的設計者以「他」(he)來稱呼,但這看來是個無意識的預設,這位智能管家能夠簡易地以「它」作為代稱。

Savioke公司的服務型機器人Relay則是個有趣的例子。在跳脫一般思維的邏輯上,它是社會性別中立的,例如配戴著由粉紅色漸層至藍色的顯示器。雖然Relay不會說話,但設計團隊積極宣傳Relay的特質─迷人、有禮貌和誠實,它是一位「智能管家(Botlr)」,(Botlr一詞由英文的「管家(butler)」變化而來)。Relay的頭頂能夠開啟,用來為飯店顧客遞送毛巾、報紙及其他服務物品。雖然Savioke的設計者以「他」(he)來稱呼,但這看來是個無意識的預設,這位智能管家能夠簡易地以「它」作為代稱。

Relay的外觀也能夠客製化,它能夠配戴黑色(男性)領結,但同時又有黃色與粉紅色的條紋,讓機器人的社會性別更加模糊。

Relay的外觀也能夠客製化,它能夠配戴黑色(男性)領結,但同時又有黃色與粉紅色的條紋,讓機器人的社會性別更加模糊。

若將領結換成湖水藍色、身穿粉紅色夾克以及冠以女性化名字,機器人Relay便成了「金娜(Jena)」。新加坡烏節門今旅(Hotel Jen Orchardgateway)為Savioke公司的客戶之一,即客製化Relay以符合自身品牌主題,並取名為「金娜(Jena)」。

若將領結換成湖水藍色、身穿粉紅色夾克以及冠以女性化名字,機器人Relay便成了「金娜(Jena)」。新加坡烏節門今旅(Hotel Jen Orchardgateway)為Savioke公司的客戶之一,即客製化Relay以符合自身品牌主題,並取名為「金娜(Jena)」。

機器人也可依照族群客製化。

機器人也可依照族群客製化。

Milo是為有泛自閉症障礙(ASD)的學習者所設計的機器人。由於自閉症影響男孩的比例較女孩高出四倍,所以Milo做成男性外型或許是對的。然而為數百萬受到自閉症困擾的女孩設計一個教學機器人也很重要。不過,Milo有趣的地方在於他有不同的膚色能夠選擇。

3. 設計無社會性別機器人

機器人學家可以選擇設計無社會性別機器人。Matilda(雖然有著女性化名字)就是一個無社會性別機器人,用於澳洲的養老院與一些特殊教育教室中。輔助型機器人Matilda有著嬰兒的外觀和孩童般的聲音。童顏機器人––例如大眼睛、小下頦––通常被認為是天真無害的(Powers

& Kiesler,

2006)。近期研究發現,失智症患者能夠享受和如嬰孩般的Matilda的互動連結,另有83%的參與者表示很喜歡與Matilda接觸,也有72%的人表示見到Matilda可以感到放鬆(Khosla

et al., 2013; Tam & Khosla, 2016)。

機器人學家可以選擇設計無社會性別機器人。Matilda(雖然有著女性化名字)就是一個無社會性別機器人,用於澳洲的養老院與一些特殊教育教室中。輔助型機器人Matilda有著嬰兒的外觀和孩童般的聲音。童顏機器人––例如大眼睛、小下頦––通常被認為是天真無害的(Powers

& Kiesler,

2006)。近期研究發現,失智症患者能夠享受和如嬰孩般的Matilda的互動連結,另有83%的參與者表示很喜歡與Matilda接觸,也有72%的人表示見到Matilda可以感到放鬆(Khosla

et al., 2013; Tam & Khosla, 2016)。

軟銀的NAO則是另一個如孩童般的無社會性別機器人例子(Obaid et

al., 2016)。雖然設計者以「他」(he)來稱呼NAO,但多數人仍認定NAO是不具社會性別的(Otterbacher &

Talias,

2017)。該機器人的外觀是一個特徵;其聲音又是另一個特點。NAO的預設聲音(操作系統版本1.x)是個合成的男孩聲,名叫肯尼(Kenny)(Sandygulova

& O’Hare, 2015),同時也能調整成較高的音頻來代表女孩。

軟銀的NAO則是另一個如孩童般的無社會性別機器人例子(Obaid et

al., 2016)。雖然設計者以「他」(he)來稱呼NAO,但多數人仍認定NAO是不具社會性別的(Otterbacher &

Talias,

2017)。該機器人的外觀是一個特徵;其聲音又是另一個特點。NAO的預設聲音(操作系統版本1.x)是個合成的男孩聲,名叫肯尼(Kenny)(Sandygulova

& O’Hare, 2015),同時也能調整成較高的音頻來代表女孩。

本田(Honda)的ASIMO(Advanced Step in Innovative Mobility)沒有明顯的社會性別線索,它說話時是小孩的聲音。然而,問題在於即使設計者將機器人打造為中性外表,但人們仍會預設機器人的社會性別身份。而ASIMO因為外觀身形及行為,很容易會被視為是男性。

4. 設計性別流動的機器人,優先考量性別平等

據我們所知,機器人學家尚未以性別流動做試驗。

5.

遠離人類社交關係

5.

遠離人類社交關係

為了避免人類的刻板印象,有些機器人設計者選擇直接遠離人類關係。以照護型機器人RIBA-II為例,它由日本公司所設計,用於協助挪移病患或年長者,因此日本設計者將其機器人打造為一只大型泰迪熊的樣子,而不使用人類外觀––藉此將機器移出人類的社會性別關係之外。

6.

設計「專屬機器人」的認同,避免社會刻板印象

6.

設計「專屬機器人」的認同,避免社會刻板印象

夫朗和婓協會與Phoenix設計公司製作的Care-O-Bot 4很有意思,因為它被設計成「既非人亦非機器」,而是某種被稱作是「技術型態(technomorphic)」且「標誌性」的東西(Kittmann et al., 2015)。該團隊網羅了產品設計者、機器人學家、軟體工程師與使用者經驗設計者,以人為中心進行設計,避開了人類的特徵,包括社會性別,目的是要避免引發使用者對機器人能力的不切實際期望。這個標誌性的設計,根據團隊表示是開放解讀的:「偏好男性機器人的人可能會將其視作男性,而偏好女性機器人的人也能從相同的設計中看到想要的」(Parlitz et al., 2008)。

它的設計者們力求打造一個「具吸引力及親切感」的機器人(Kittmann et al.,

2015)。在照護情境下,它傳遞情緒的方式是透過姿勢(主要是使用它顯示在螢幕上的眼睛以及斜翹的頭部等)。它的「頭」是一個觸控面板,搭載了鏡頭與感應器,用來「看」使用者的姿勢,外加臉部辨識以估算使用者的社會性別、年齡以及情緒。

雖然設計者稱Care-O-Bot是「紳士」,但它的運作大多是不在社會性別規範之內的。Care-O-Bot亦是個社會性別中立的名字,使用者可以自行為機器人取名,並且在40種不同語言中選擇使用男性或女性的聲音。

結論

我們以希波克拉底誓言提供機器人學家們作為參考:「要幫助,或至少不要傷害」(to help, at least, do no harm)。有害的設計來自於在過程中,設計者們無意識地迎合某些社會性別刻板印象,即有可能會以非機器人學家本意的方式加深這些刻板印象。機器人學家將有機會介入影響人類世界。我們已知科技對人類文化有所影響,例如:電動遊戲會影響玩家在現實世界的行為。研究顯示暴力遊戲(第一人稱視角的射擊遊戲如《德軍總部3D》或第三人稱視角的對戰遊戲如《真人快打系列》),可在短時間內提高玩家們對於具攻擊性的想法與念頭(Anderson et al., 2007)。研究也顯示,以「為其他遊戲角色謀福利」為目標的利他型遊戲能使玩家採取利他性社會行為,亦即旨在幫助他人的自發性行為(Greitemeyer & Osswald, 2010)。機器人也能以類似的方式對社會性別規範帶來影響。機器人能夠再製社會性別刻板印象,抑或透過引領使用者重新思考社會性別規範的方式挑戰刻板印象。一旦機器人學家瞭解社會性別是如何被體現於機器人的設計之後,他們將能以更為安全、效率且促進社會平等的方式設計機器人。

下一步

我們建議研究者進行對照研究,探討對於機器人的社會性別認知如何形塑人類的性別規範。機器人的社會性別對於性別平等是提升還是阻礙?研究者曾透過體驗式虛擬實境做過種族相關實驗。透過虛擬實境,人們能夠體驗處在不同種族身體中的經驗,透過將歐裔美國人化身為非裔美國人有助減少內隱種族偏見(Banakou et al., 2016; Hassler et al., 2017, but see Lai et al., 2016)。我們提議,以相似的實驗測試人們對機器人社會性別的認知如何可能影響其對於性別平等的態度。

參考資料

Anderson, C., Buckley, K., & Gentile, D. (2007). Violent Video Game Effects on Children and Adolescents: Theory, Research, and Public Policy. New York: Oxford University Press.

Andrist, S., Ziadee, M., Boukaram, H., Mutlu, B., & Sakr, M. (2015, March). Effects of culture on the credibility of robot speech: A comparison between english and arabic. In Proceedings of the Tenth Annual ACM/IEEE International Conference on Human-Robot Interaction, 157-164. ACM.

Atkinson, M. (1984). Our Masters' Voices: The Language and Body-Language of Politics. London: Methuen.

Banakou, D., Hanumanthu, P. D., & Slater, M. (2016). Virtual embodiment of white people in a black virtual body leads to a sustained reduction in their implicit racial bias. Frontiers in human neuroscience, 10, 601.

Carpenter, J., Davis, J. M., Erwin-Stewart, N., Lee, T. R., Bransford, J. D., & Vye, N. (2009). Gender representation and humanoid robots designed for domestic use. International Journal of Social Robotics, 1(3), 261–265. https://doi.org/10.1007/s12369-009-0016-4

Coren, M. J. (2017, July 26). It took (only) six years for bots to start ditching outdated gender stereotypes. Quartz. Retrieved from https://qz.com/1033587/it-took-only-six-years-for-bots-to-start-ditching-outdated-gender-stereotypes/

Dattaro, L. (2015, Feb 4). Bot looks like a lady: Should robots have gender? Slate.

http://www.slate.com/articles/technology/future_tense/2015/02/robot_gender_is_it_bad_for_

human_women.

Eyssel, F., & Hegel, F. (2012). (S)he’s got the look: Gender stereotyping of robots. Journal of Applied Social Psychology, 42(9), 2213–2230. https://doi.org/10.1111/j.1559-1816.2012.00937.

Eyssel, F., & Kuchenbrandt, D. (2012). Social categorization of social robots: Anthropomorphism as a function of robot group membership. British Journal of Social Psychology, 51(4), 724-731.

Goetz, J., Kiesler, S., & Powers, A. (2003). Matching robot appearance and behavior to tasks to improve human-robot cooperation. In Proceedings of Robot and Human Interactive Communication (pp. 55–60). IEEE. https://doi.org/10.1109/ROMAN.2003.1251796

Greitemeyer, T., & Osswald, S. (2010). Effects of prosocial video games on prosocial behavior. Journal of Personality and Social Psychology, 98 (2), 211-221.

Hasler, B. S., Spanlang, B., & Slater, M. (2017). Virtual race transformation reverses racial in-group bias. PloS one, 12(4), e0174965.

Jung, E. H., Waddell, T. F., & Sundar, S. S. (2016). Feminizing robots: User responses to gender cues on robot body and screen. In Proceedings of the 2016 CHI Conference Extended Abstracts on Human Factors in Computing Systems (pp. 3107–3113). San Jose, CA.

Khosla, R., Chu, M.-T., & Nguyen, K. (2013). Affective robot enabled capacity and quality improvement of nursing home aged care services in Australia. Presented at the Computer Software and Applications Conference Workshops, Japan: https://doi.org/10.1109/COMPSACW.2013.89

Kittmann, R., Fröhlich, T., Schäfer, J., Reiser, U., Weißhardt, F., & Haug, A. (2015). Let me introduce myself: I am Care-O-bot 4, a gentleman robot. Mensch und computer 2015–proceedings.

Knight, W. (2017, August 16). AI programs are learning to exclude some African-American voices. MIT Technology Review.

Lai, C. K., Skinner, A. L., Cooley, E., Murrar, S., Brauer, M., Devos, T., ... & Simon, S. (2016). Reducing implicit racial preferences: II. Intervention effectiveness across time. Journal of Experimental Psychology: General, 145(8), 1001.

Li, D., Rau, P. P., & Li, Y. (2010). A cross-cultural study: Effect of robot appearance and task. International Journal of Social Robotics, 2(2), 175-186.

Makatchev, M., Simmons, R., Sakr, M., & Ziadee, M. (2013). Expressing ethnicity through behaviors of a robot character. In Proceedings of the 8th ACM/IEEE international conference on Human-robot interaction (pp. 357-364). IEEE Press. Nass, C., & Moon, Y. (2000). Machines and mindlessness: Social responses to computers. Journal of Social Issues, 56(1), 81–103.

Nass, C., & Moon, Y. (2000). Machines and mindlessness: Social responses to computers. Journal of Social Issues, 56(1), 81–103. https://doi.org/10.1111/0022-4537.00153

Nass, C., Moon, Y., & Green, N. (1997). Are machines gender neutral? Gender‐stereotypic responses to computers with voices. Journal of applied social psychology, 27(10), 864-876.

Obaid, M., Sandoval, E. B., Złotowski, J., Moltchanova, E., Basedow, C. A., & Bartneck, C. (2016, August). Stop! That is close enough. How body postures influence human-robot proximity. In Robot and Human Interactive Communication (RO-MAN), 2016 25th IEEE International Symposium on (pp. 354-361). IEEE.

Otterbacher, J., & Talias, M. (2017, March). S/he's too warm/agentic!: The influence of gender on uncanny reactions to robots. In Proceedings of the 2017 ACM/IEEE International Conference on Human-Robot Interaction, 214-223).

Parlitz, C., Hägele, M., Klein, P., Seifert, J., & Dautenhahn, K. (2008). Care-o-bot 3-rationale for human-robot interaction design. In Proceedings of 39th International Symposium on Robotics (ISR), Seoul, Korea, 275-280.

Powers, A., & Kiesler, S. (2006, March). The advisor robot: Tracing people's mental model from a robot's physical attributes. In Proceedings of the 1st ACM SIGCHI/SIGART conference on Human-robot interaction (pp. 218-225). ACM.

Rea, D. J., Wang, Y., & Young, J. E. (2015, October). Check your stereotypes at the door: An analysis of gender typecasts in social human-robot interaction. In International Conference on Social Robotics, 554-563.

Reich-Stiebert, N., & Eyssel, F. (2017, March). (Ir) relevance of gender?: On the influence of gender stereotypes on learning with a robot. In Proceedings of the 2017 ACM/IEEE International Conference on Human-Robot Interaction, 166-176.

Sandygulova, A., & O’Hare, G. M. (2015). Children’s perception of synthesized voice: Robot’s gender, age and accent. In International Conference on Social Robotics, 594-602.

Tam, L., & Khosla, R. (2016). Using social robots in health settings: Implications of personalization for human-machine communication. Communication+ 1, 5.

Wang, Y., & Young, J. E. (2014, May). Beyond pink and blue: Gendered attitudes towards robots in society. In Proceedings of Gender and IT Appropriation. Science and Practice on Dialogue-Forum for Interdisciplinary Exchange. European Society for Socially Embedded Technologies.

Wang, Z., Huang, J., & Fiammetta, C. (2021). Analysis of Gender Stereotypes for the Design of Service Robots: Case Study on the Chinese Catering Market. In Designing Interactive Systems Conference 2021, 1336-1344.

機器人是在一個活躍著社會性別常模、社會性別認同與社會性別關係的世界中被設計出來的。人類—無論是設計者或使用者,常會將機器性別化(因為在人類文化中,社會性別是個主要的社會分類)。

其中的危險在於迎合當前的刻板印象來設計硬體,可能會強化這些刻板印象。一旦使用者給機械指定了社會性別,刻板印象便隨之而來。機器人與人工智慧的設計者不只是創造出反映社會的產品而已,他們(或許是無意地)也再次強化及認可了某些被視為對於女人、男人或性別多元者而言是恰當的社會性別規範(例如,社交態度與行為)。設計者的挑戰在於瞭解社會性別是如何被體現在機器人上的,藉此設計出能夠有助社會公平的機器人。

性別化創新:

1. 瞭解社會性別是如何被體現在機器人上

2. 設計有助社會平等的機器人

此案例分析探究:人類是如何將社交機器人「性別化」的?機器人是否提供了打造更公平的社會性別規範的新契機?我們能如何將具社會責任的機器人設計到最好?