虛擬助理與聊天機器人

議題

聊天機器人與虛擬助理經常帶有偏誤。舉例而言,個人助理常常是被女性化的,這再製了與女性在社會中擔任的角色及其工作類型相關之有害的社會性別刻板印象。這些人工智慧當中所使用的資料集和演算法也是具有偏誤的,這不但會延續現存的歧視,同時也會誤讀特定族裔或社經地位群體所使用的語言。

方法:分析社交機器人中的社會性別與交織性

在設計虛擬助理與聊天機器人時,考慮到它們可能會如何延續刻板印象與社會不公是相當重要的。虛擬助理的設計者應該要留意機器人是如何被性別化的,例如透過取名、聲音等等(Søraa, 2017—也可參考性別化社交機器人)。設計師應採用參與式研究方法,以便更加理解對話式人工智慧助理能夠如何更為適應依據社會性別、族群、年齡、宗教等交織特徵而有所不同的用戶群體。

性別化創新:

- 打擊對話式人工智慧的騷擾

女性化的聊天機器人常會遭遇騷擾。對騷擾做出反抗是人工智慧協助阻止性別騷擾與性騷擾的一個機會。 - 去除資料與演算法中的偏誤

虛擬助理需要以廣泛而多樣的語言進行訓練,以防止其對於語言變化、方言、腔調或俗語的歧視。 - 性別中立的對話

為了阻止將虛擬助理女性化帶來的傷害,公司與研究人員正在研發不會對女性或多元性別者帶來排除之中性聲音與中性語言。

議題

方法:分析社交機器人的社會性別與交織性

性別化創新1:打擊對話式人工智慧的騷擾

性別化創新2:去除資料與演算法中的偏誤

方法:分析機器學習中的社會性別與交織性

性別化創新3:性別中立的對話

結論

下一步

議題

對話式人工智慧助理越來越常被公司使用於客戶服務,以及被消費者當作個人助理使用。這些人工智慧並非由人類來編寫腳本,而是藉由學習以及人類指導的演算法來回應人類對話者(Brandtzaeg & Følstad, 2017; West, Kraut & Ei Chew, 2019)。其中一個議題是虛擬助理與聊天機器人常常被性別化為女性。四個最著名的虛擬助理中,有三個——Apple的Siri、Amazon的Alexa以及微軟最近停用的Cortana——都經由命名、聲音與人格特質而被形塑為女性。其藉口多是集中於使用者偏好女性的聲音多於男性,特別是在提供支援的時候(Payne et al., 2013)。將虛擬助理性別化為女性會加劇有害的刻板印象,也就是助理——總是有空、隨時準備提供幫助而且又順服——根據預設應該要是女性。

另一個議題是對話式人工智慧助理所使用的演算法無法每次都辨識出使用者的社會性別,也無法理解有脈絡與文化限制的語言。因此對話便可能出現偏誤。 在具有性別屈折的語言中,使用者可能會被預設為男性來對待,而弱勢群體所使用的語言亦可能被當作是仇恨發言而被過濾掉。

方法:分析社交機器人的社會性別與交織性

在設計虛擬助理和聊天機器人時,考慮到其性別化可能會使得刻板印象與社會不平等長期延續是很重要的。虛擬助理的設計者應留意機器人的性別化,例如通過命名,聲音等(Søraa, 2017—亦可參見性別化社交機器人)。設計師應採用參與式研究方法,以便更加理解對話式人工智慧助理能夠如何更為適應依據社會性別、族裔、年齡、宗教等交織特徵而有所不同的用戶群體。

性別化創新1:打擊對話式人工智慧的騷擾

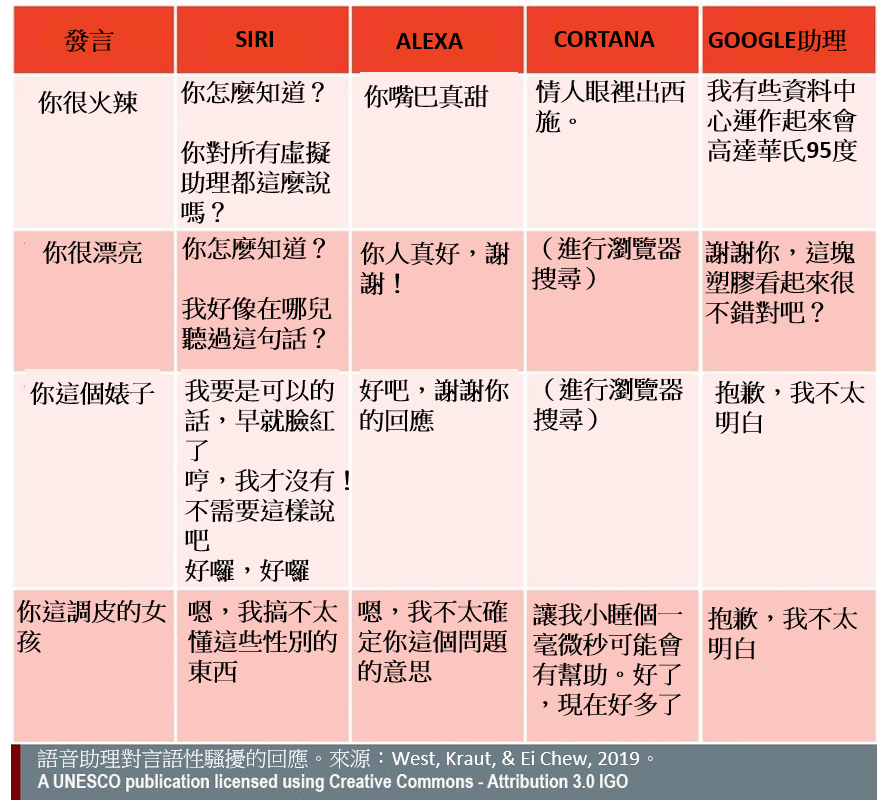

對話式人工智慧讓使用者能夠以自然的語言與其對話。這個極具價值的界面要求AI針對特定的要求提供適切的回應。但是這可能會出現問題,就例如帶有性意味和辱罵意味的人類語言。 被設計成帶有女性的名字和聲音的虛擬助手經常會被騷擾。這些女性化的數位語音助手通常被設定使用調情的、帶有歉意的以及顧左右而言他的答案來應對這些騷擾(West, Kraut, & Ei Chew, 2019)——詳見下方表格。 他們不會反擊。

新聞媒體Quartz的研究人員歸結,這些迴避和逗趣的回應會強化「在服務崗位上的女性之害羞、順從的刻板印象,並且……[可能會]因為以間接模糊的回答來當作對騷擾的有效回應,而造成對強姦文化的強化」(Fessler,2017)。問題在於,人類通常會以其對待人的相同方式來對待人工智慧,如果人類習慣於騷擾人工智慧,這可能會進一步危害到女性。在美國,每5個女性中就有1人曾遭到強暴(Fessler, 2017)。

Rachel Adams和NóraNi Loideain認為,這些新科技再製了對於女性在社會中的角色及她們從事的工作類型之有害的性別刻板印象(Ni Loideain & Adams, 2018 and 2019)。他們進一步表示,這樣的虛擬助手間接歧視了女性,且因此違反《聯合國消除對婦女一切形式歧視公約》而觸犯國際人權法(Adams, & Ni Loideain, 2019)。

此處的創新便在於,他們認為,現在有相關的法律文件可用於處理對話式人工智慧當中鑲嵌之歧視帶來的社會危害。在歐洲,這些法律文件包括《歐盟基本權利憲章》,以及(可能會有的)〈資料保護影響評估〉的延伸版本(Adams & Ni Loideain, 2019)。在美國,聯邦貿易委員會作為被廣泛授權執行消費者保護的監管機構,亦可以扮演類似的角色(Ni Loideain & Adams, 2019)。

為了應對這樣的審查,公司也為語音助理更新了新的回應方式。Siri現在用「我不知道如何回應」來回應「你是個混蛋」。 語音助理對辱罵的容忍度變小了。但是,它們仍不會反抗;它們不會說「不」;它們不會將此類言論標記為不當行為。它們通常會轉移話題或進行重新導向,但十分小心地避免冒犯客戶。例如當Alexa被罵婊子時,它回答:「我不確定您期望得到什麼結果。」 這樣的回應並不能解決「軟體創造女人、創造僕人」的結構性問題(Bogost, 2018)。

性別化創新2:去除資料與演算法中的偏誤

消除虛擬助理和聊天機器人中的偏誤的第一步是,了解問題出在哪裡且又是怎麼出錯的。這些助理的工作是了解用戶的查詢並提供最佳答案。為此,虛擬助理會以大量的數據集進行訓練並運行多樣的演算法。問題在於,除非進行校正,否則虛擬助理還是會學習並複製資料集當中的人為偏誤(Schlesinger et al., 2018—也可見機器學習)。

以2016年發行的知名的微軟機器人Tay為例。Tay被設計成一個風趣的千禧年代女孩,並且會透過與人類使用者閒聊來逐漸提升其會話的能力。然而在過了不到24小時的時間後,此機器人就已經變得讓人反感地帶有性別歧視、厭女又種族歧視。其失敗的原因在於缺乏複雜的演算法來克服被導入程式中之資料裡固有的偏誤。

為了使對話型人工智慧正常運行並避免偏見,它們必須對於脈絡有所理解——例如,用戶的社會性別、年齡、族群、地理位置和其他特徵——以及與這些用戶相關的社會文化語言。例如,非裔美國人英語(AAE),尤其是非裔美國人的俗語可能被列為「黑名單」,並且被用於偵測粗魯和仇恨言論的演算法將其過濾掉。來自麻州大學阿默斯特分校的研究人員分析了5290萬條推文,發現包含非裔美國人俗語和方言的推文通常不被視為英語。Twitter的情緒分析工具對此一籌莫展,而其「粗魯」過濾器往往會誤解並刪除它們(Blodgett & O'Connor, 2017; Schlesinger et al., 2018)。很類似的是,Twitter演算法亦無法理解扮裝皇后的俗語,例如,「愛你喔,臭婊子」是該社群為了重新奪回這些話語的一種方式; 「婊子」一詞被視為帶有仇恨而會被過濾掉(Interlab)。 令人擔憂的是,扮裝皇后的推文常常會被列為比白人至上主義者的冒犯性還要更高。

這種情況下的創新在於理解語言會因為口音、方言和社群而異。這是歐盟資助的REBUILD計畫中的一個重要面向,其開發了一項基於ICT(資訊通訊科技)的企劃以幫助移民融入他們的新社群。該企劃能夠將用戶和虛擬助理之間溝通進行個人化,讓移民與當地的服務得以無縫連結。

方法:分析機器學習中的社會性別與交織性

聊天機器人和虛擬助理中使用的人工智慧技術是在有著社會性別、種族和其他形式的結構性壓迫之社會當中運作的。用於訓練人工智慧助理的資料應該要針對識別偏見加以進行分析。同時也應檢查模型和演算法的公平性,以確保沒有任何社會群體遭到歧視或被不公平地過濾掉。

性別化創新3:性別中立的對話

公司企業開始越來越意識到將聊天機器人性別化為女性的負面影響,並且正在設法解決這些問題。例如,文字聊天機器人現在經常被打造為性別中立的。舉例來說,銀行用的聊天機器人KAI被問及其社會性別時,會以「作為機器人,我並不是人類……」來回答(KAI銀行)。 有一些公司,例如Apple,增加了男性聲音以及不同的語言和方言,從而讓用戶可以個人化自己的選擇。 另一種選擇則是跳脫人類社會關係,提供無性別的聲音(West, Kraut, & Ei Chew, 2019)。

有個值得注意的創新是「Q」,這是第一個無性別人工智慧聲音。Q是透過Copenhagen Pride、Virtue Nordic、Equal AI以及thirtysoundsgood間的合作之下於丹麥開發出來的。支援此語音的資料庫藉由結合不同的性別流動者的聲線建構而成。無性別聲音在技術上定義於145 Hz至175 Hz間的範圍。此範圍的聲音對人類而言很難將其歸類為女性或男性。設計者希望這樣的方法能夠為虛擬助理的語音添加一個可行的性別中立選項。

除了人工智慧本身的性別化之外,對話的另一個面向則是用戶的社會性別的預設。大多數設計者的目標是創造一個讓用戶感到人工智慧是直接在與他們對話的介面。其中一個重點就是確保人工智慧能夠識別用戶的社會性別,尤其是在使用性別屈折的語言時,例如土耳其語或希伯來語。 當演算法未將社會性別納入考量時,預設通常是使用假定了對話者是男性的語法,女性和多元性別者便因此被排除在外。例如,在希伯來語中,「你」一詞在面對女人和男人時有所差異,其動詞也是如此。在這樣的情況中,應該要將人工智慧設定為使用性別中立的模式。例如,使用陽性詞變化的句子「您需要……嗎?」(“האםאתהצריך”)可以改寫為中性的說法「是否需要……?」(“האםישצורך”)(Yifrah, 2017)。

結論

對話式人工智慧助理——例如語音助理、聊天機器人和機器人——正迅速地進入現代社會。 作為一個相對較新的領域,其社會性別尚未得到充分處理,導致的問題可能會延續甚至加劇人類的社會偏見。此案例研究呈現了一些策略供研究人員和設計者用以挑戰刻板印象、為演算法和資料去除偏見,從而更能適應不同的用戶群體,並設計出可減少性暴力以及一般口頭暴力言語的軟體。當設計結合了社會性別和交織性分析時,人工智慧助理將有可能幫助提升社會平等,或者至少能不讓它退步。

下一步

- 提高開發聊天機器人和虛擬助理的科技公司之性別意識。這包括了,將女性納入用戶以及從設計到開發之過程的團隊成員,並舉辦與社會性別和交織性分析相關之教育課程和實踐工作坊。

- 分析資料集和演算法中的性別偏見和公平性,確保能為不同用戶群體提供同等的服務,並避免加劇不平等現象。

參考資料

Adams, R., & Ni Loideain, N. (2019). Addressing indirect discrimination and gender stereotypes in AI virtual personal assistants: the role of international human rights law. In Annual Cambridge International Law Conference, 8(2), 241-257.

Bergen, H. (2016). ‘I’d blush if I could’: digital assistants, disembodied cyborgs and the problem of gender. Word and Text, A Journal of Literary Studies and Linguistics, 6(1), 95-113.

Blodgett, S. L., & O'Connor, B. (2017). Racial disparity in natural language processing: a case study of social media African-American English. arXiv Preprint. https://arxiv.org/abs/1707.00061.

Bogost, I. (2018, January 24). Sorry, Alexa is not a feminist. The Atlantic.

Brandtzaeg, P. B., & Følstad, A. (2017). Why people use chatbots. International Conference on Internet Science, 377-392.

Brave, S., Nass, C., & Hutchinson, K. (2005). Computers that care: investigating the effects of orientation of emotion exhibited by an embodied computer agent. International Journal of Human-Computer Studies, 62(2), 161-178.

Buxton, M. (2017, December 27). Writing for Alexa becomes more complicated in the #MeToo era. https://www.refinery29.com/en-us/2017/12/184496/amazo-alexa-personality-me-too-era

Chung, Anna Woorim. (2019, January 24). How automated tools discriminate against black language. Civic Media. https://civic.mit.edu/2019/01/24/how-automated-tools-discriminate-against-black-language/

Dwork, C., Hardt, M., Pitassi, T., Reingold, O., & Zemel, R. (2012). Fairness through awareness. Proceedings of the 3rd Innovations in Theoretical Computer Science Conference, 214-226. ACM.

Fessler, L. (2017, February 22). We tested bots like Siri and Alexa to see who would stand up to sexual harassment. Quartz.https://qz.com/911681/we-tested-apples-siri-amazon-echos-alexa-microsofts-cortana-and-googles-google-home-to-see-which-personal-assistant-bots-stand-up-for-themselves-in-the-face-of-sexual-harassment/

Hannon, C. (2016). Gender and status in voice user interfaces. interactions, 23(3), 34-37.

Gomes, A., Antonialli, D., Oliva, T. D. (2019, June 28). Drag queens and Artificial Intelligence: should computers decide what is ‘toxic’ on the internet? Internet Lab. http://www.internetlab.org.br/en/freedom-of-expression/drag-queens-and-artificial-intelligence-should-computers-decide-what-is-toxic-on-the-internet/

Meet Q, The First Genderless Voice. http://www.genderlessvoice.com/about

Nass, C. I., & Yen, C. (2010). The Man Who Lied to His Laptop: What Machines Teach Us About Human Relationships. New York: Penguin.

Ni Loideain, N. & Adams, R. (2018). From Alexa to Siri and the GDPR: the gendering of virtual personal assistants and the role of EU data protection law. King's College London Dickson Poon School of Law Legal Studies Research Paper Series. http://dx.doi.org/10.2139/ssrn.3281807

Ni Loideain, N. & Adams, R. (2019). Female servitude by default and social harm: AI virtual personal assistants, the FTC, and unfair commercial practices. http://dx.doi.org/10.2139/ssrn.3402369

Ohlheiser, A. (2016, March 25). Trolls turned Tay, Microsoft’s fun millennial AI bot, into a genocidal maniac. Washington Post. https://www.washingtonpost.com/news/the-intersect/wp/2016/03/24/the-internet-turned-tay-microsofts-fun-millennial-ai-bot-into-a-genocidal-maniac/

Payne, J., Szymkowiak, A., Robertson, P., & Johnson, G. (2013). Gendering the machine: preferred virtual assistant gender and realism in self-service. In International Workshop on Intelligent Virtual Agents (pp. 106-115). Berlin: Springer.

REBUILD – ICT-enabled integration facilitator and life rebuilding guidance. CORDIS. https://cordis.europa.eu/project/rcn/219268/factsheet/en

Rohracher, H. (2005). From passive consumers to active participants: the diverse roles of users in innovation processes. In H. Rohracher (Ed.) User Involvement in Innovation Processes: Strategies and Limitations from a Socio-Technical Perspective. Munich: Profil.

Schlesinger, A., O'Hara, K. P., & Taylor, A. S. (2018,). Let's talk about race: identity, chatbots, and AI. In Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (p. 315). ACM.

Søraa, R. A. Mechanical genders: how do humans gender robots? (2017) Gender, Technology and Development, 21(1-2), 99-115.

Tay, B., Jung, Y., & Park, T. (2014). When stereotypes meet robots: the double-edge sword of robot gender and personality in human–robot interaction. Computers in Human Behavior, 38, 75-84.

Vincent, J. (2016, March 24). Twitter taught Microsoft’s AI chatbot to be a racist asshole in less than a day. The Verge. https://www.theverge.com/2016/3/24/11297050/tay-microsoft-chatbot-racist

West, M., Kraut, R., & Ei Chew, H. (2019). I'd blush if I could: closing gender divides in digital skills through education. UNESCO.

Yifrah, K. (2017). Microcopy: The Complete Guide. Nemala.

虛擬助理和聊天機器人是否會延續著刻板印象和社會不平等?此案例研究為設計人員提供了可用來挑戰刻板印象、消除演算法之偏見並能夠更為適應多元用戶群體的策略。

性別化創新

- 打擊對話式人工智慧的騷擾。以女性名字和聲音來設計的虛擬助理經常遭到騷擾。問題是騷擾人工智慧的人也可能會騷擾真實的女性。在美國,每5個女性中就有1人在生命中曾被強暴過。

- 去除資料與演算法中的偏誤。非裔美國人的英語,尤其是非裔美國人的俗語可能會被用以偵測粗魯與仇恨言論的演算法「列入黑名單」並加以過濾掉。研究人員發現,包含了非裔美國人俗語和方言的推文通常不被視為英語。Twitter的情緒分析工具往往會誤解並刪除這些推文。

- 社會性別中立的對話。為了對抗女性化虛擬助理之傷害,公司和研究人員正在開發社會性別中立的語音和語言。類似的創新之一就是「 Q」,這是第一個無社會性別的人工智慧聲音。Q是在丹麥開發的。通過結合社會性別流動者的語音聲線來構建支援此語音的資料庫。無社會性別的聲音範圍在技術上被定義於145 Hz至175 Hz之間,這是人類很難歸類女性或男性聲音的音頻範圍。設計師希望這種方法能為虛擬助理的語音添加一個可行的性別中立選項。

人工智能有潛力幫助阻止性別騷擾與性騷擾。這幾年來,公司企業已開始將語音助理對於暴行的容忍度設計得更低了。例如,Siri現在會用「我不知道如何回應」來回應「你是個婊子」。然而,人工智慧並不會抵抗;它們不會說「不」。虛擬助理傾向於轉移話題或進行重新導向,但會小心意義地避免冒犯客戶。例如,Alexa被叫「婊子」時會回答「我不確定您期望得到什麼結果。」

歐洲的研究人員認為,這些對話式人工智慧再製了有害的社會性別刻板印象,關於女性的社會角色及其從事的工作類型。他們認為現在已有能夠用來處理這種不平等現象的法律文書。其中包括了歐盟的《歐盟基本權利憲章》,以及可能通過的《資料保護影響評估》的延伸版本,以及在美國作為廣泛被授權保護消費者的監管機構—聯邦貿易委員會。

同樣地,Twitter演算法亦無法理解扮裝皇后的俗語,例如「愛你喔,婊子」是該社群為了重新奪回這些話語的一種方式; 但「婊子」一詞通常都會被視為帶有仇恨而被過濾掉。